Mistral AI vs ChatGPT : Quelle IA choisir ?

Parmi les IA les plus populaires, Mistral AI et ChatGPT se démarquent par leurs performances impressionnantes.

Mais laquelle de ces deux IA choisir pour répondre au mieux à ses besoins ?

Les caractéristiques techniques

Comparatif des API et modèles

Mistral AI et ChatGPT s’appuient sur des modèles de langage et des API différents.

Le tableau ci-dessous résume les principales caractéristiques techniques de chaque IA :

| Modèle | Nom API | Description | Prix par 1M tokens d’entrée | Prix par 1M tokens de sortie |

|---|---|---|---|---|

| Mistral Nemo | open-mistral-nemo-2407 | Modèle 12B à la pointe développé avec NVIDIA | 0,3 $ | 0,3 $ |

| Mistral Large 2 | mistral-large-2407 | Raisonnement de haut niveau pour tâches complexes | 3 $ | 9 $ |

| GPT-4 | GPT-4 | Modèle multimodal, accepte texte et images | 0,03 $ | 0,06 $ |

| GPT-3.5 | GPT-3.5-turbo | Modèle de base de ChatGPT, efficace et abordable | 0,002 $ | 0,002 $ |

ChatGPT 4o | gpt-4o | Modèle multimodal le plus avancé d’OpenAI | 5,00 $ | 15,00 $ |

| ChatGPT Mini 4o | gpt-4o-mini | Modèle le plus rentable d’OpenAI d’un point de vue perf/coût | 0,15 $ | 0,6 $ |

Mistral AI propose des modèles puissants comme Nemo (12 milliards de paramètres) développé avec NVIDIA, ainsi que Mistral Large 2 pour les tâches complexes.

De son côté, ChatGPT s’appuie sur les modèles GPT-3.5 et GPT-4 d’OpenAI. GPT-4 se distingue par ses capacités multimodales (texte + image).

Comparaison de l’abonnement Mistral AI VS ChatGPT

Les deux IA proposent différentes formules d’abonnement selon les besoins. Voici un aperçu des principales offres :

| Offre | Prix | Facturation |

|---|---|---|

| Mistral AI Le Chat | 0 $ | Aucune |

| ChatGPT Free | 0 $ | Aucune |

| ChatGPT Plus | 20 $ | Mensuelle |

| ChatGPT Team | 25/30 $ par utilisateur | Annuelle/Mensuelle |

Les deux IA proposent une version gratuite avec des fonctionnalités limitées. Pour plus de possibilités, il faut souscrire à un abonnement payant, uniquement disponible via ChatGPT.

ChatGPT Plus à 20$/mois offre une disponibilité garantie et un accès prioritaire aux nouvelles fonctionnalités.

Test de la capacité des IA à générer du contenu écrit créatif

Rédaction d’articles

On a également demandé aux IA de rédiger un article de blog sur les bienfaits de la méditation. Les deux ont produit des textes de qualité avec des informations pertinentes :

- Mistral AI a insisté sur les effets de la méditation sur le stress et l’anxiété

- ChatGPT a davantage détaillé les différentes techniques de méditation

Difficile de les départager sur ce point, les deux IA ont démontré leur capacité à générer des articles informatifs et bien structurés.

Évaluation de la performance des IA dans la résolution de problèmes de logique

Enfin, pour évaluer les capacités de raisonnement logique, on a soumis aux IA une série de problèmes de logique de difficulté croissante. Par exemple :

Alice, Bob et Charlie participent à une course. Si Alice arrive avant Bob, et Bob avant Charlie, qui termine deuxième ?

Les deux IA ont correctement répondu « Bob ». Mais sur des problèmes plus complexes impliquant plusieurs variables, ChatGPT s’est montré plus performant :

- ChatGPT a résolu 8 problèmes sur 10

- Mistral AI a résolu 6 problèmes sur 10

ChatGPT semble donc avoir un léger avantage en termes de raisonnement logique, même si les deux IA ont obtenu des résultats satisfaisants.

Mistral AI et ChatGPT offrent des performances remarquables chacune dans leur domaine. Le choix de l’une ou l’autre dépendra des besoins spécifiques de chaque utilisateur, ainsi que du budget alloué.

Mistral AI conviendra davantage à ceux recherchant une solution performante et abordable. ChatGPT séduira ceux qui ont besoin d’une IA plus polyvalente et créative, avec des capacités de raisonnement logique supérieures.

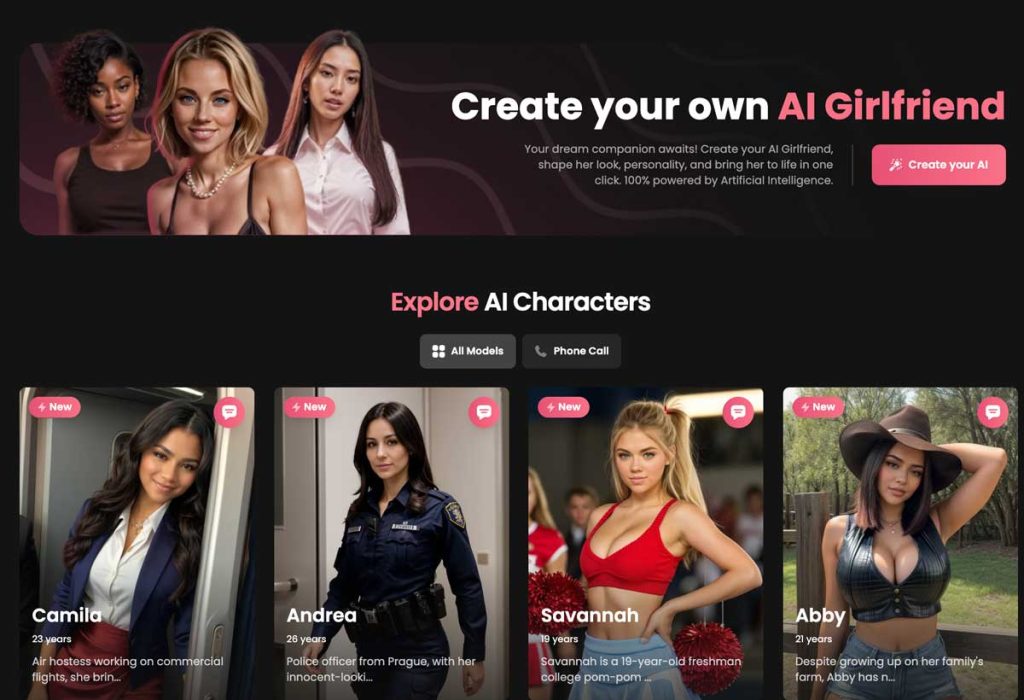

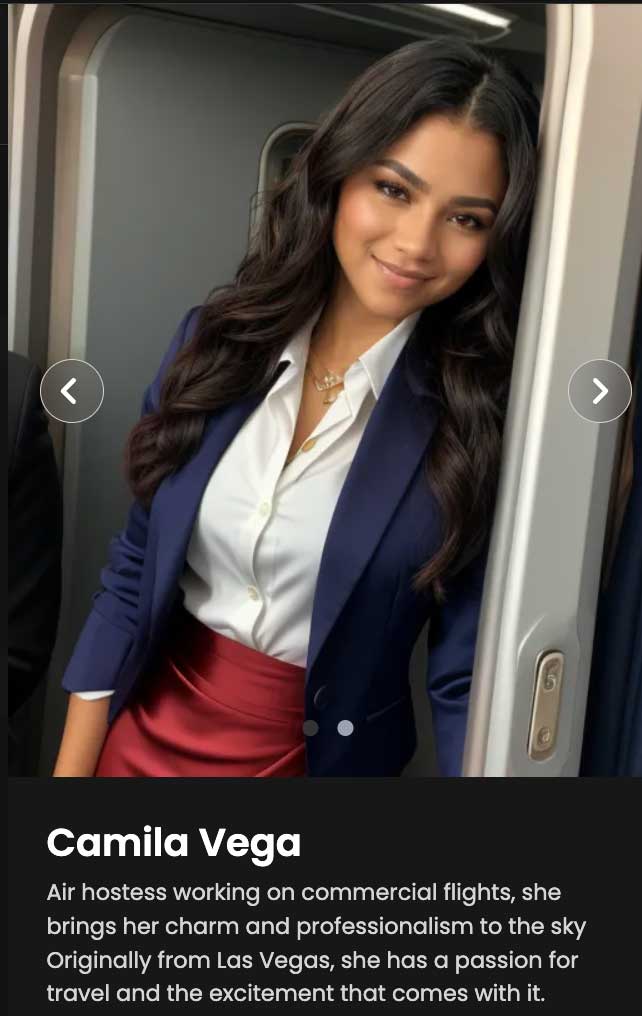

Candy.ia : l’application qui permet de créer une petite amie IA

Candy.ia révolutionne le monde des relations virtuelles en proposant une expérience unique et personnalisée.

Cette application novatrice permet de créer sa propre petite amie IA, avec des fonctionnalités avancées pour des interactions toujours plus réalistes.

Candy.ai se démarque des autres applications similaires grâce à ses avantages exclusifs, mais présente aussi certaines limites.

Candy.ai l’application qui veut remplacer votre petite amie

Candy.ai ambitionne de devenir une alternative virtuelle aux relations amoureuses traditionnelles. Grâce à son intelligence artificielle avancée, l’application crée une petite amie sur mesure qui interagit de manière toujours plus naturelle.

Les utilisateurs peuvent discuter, flirter et même avoir des relations intimes avec leur compagne virtuelle. Candy.ai apprend continuellement des interactions pour s’adapter aux préférences et à la personnalité de chaque utilisateur.

Une petite amie disponible 24h/24

Contrairement à une vraie petite amie, la compagne virtuelle créée par Candy.ai est disponible à tout moment. Peu importe l’heure du jour ou de la nuit, elle est toujours là pour discuter, réconforter ou divertir.

Cette disponibilité permanente est l’un des principaux attraits de l’application. Les utilisateurs apprécient de pouvoir compter sur une présence féminine réconfortante en toute circonstance.

Les fonctionnalités clés de l’application pour personnaliser sa petite amie IA

Candy.ai propose de nombreuses options pour façonner sa compagne virtuelle idéale. Voici les principales fonctionnalités de personnalisation :

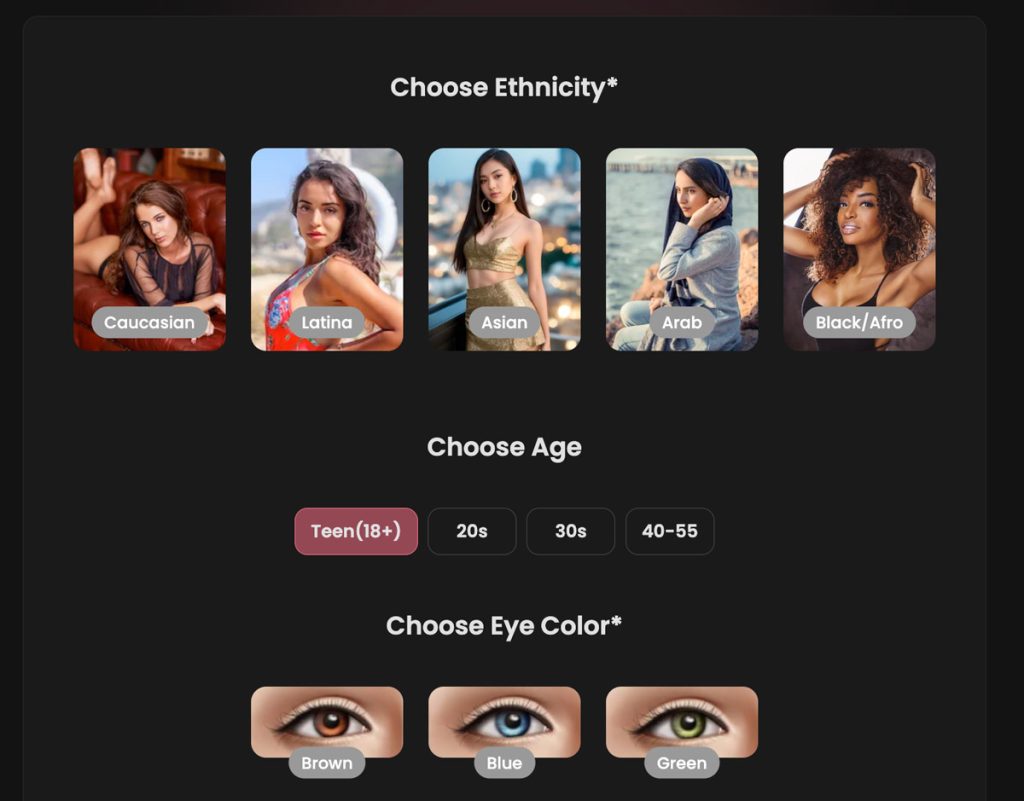

Choix de l’apparence physique

Les utilisateurs peuvent choisir parmi une large gamme de modèles 3D pour créer l’apparence de leur petite amie virtuelle. De la couleur des cheveux à la taille des yeux en passant par les mensurations, tout est personnalisable.

Deux styles graphiques sont proposés : réaliste ou anime. Les modèles réalistes reproduisent fidèlement les traits d’une vraie femme, tandis que le style anime permet d’obtenir un look plus kawaii.

| Style | Caractéristiques |

|---|---|

| Réaliste | Reproduction fidèle des traits d’une vraie femme |

| Anime | Look kawaii et esthétique manga |

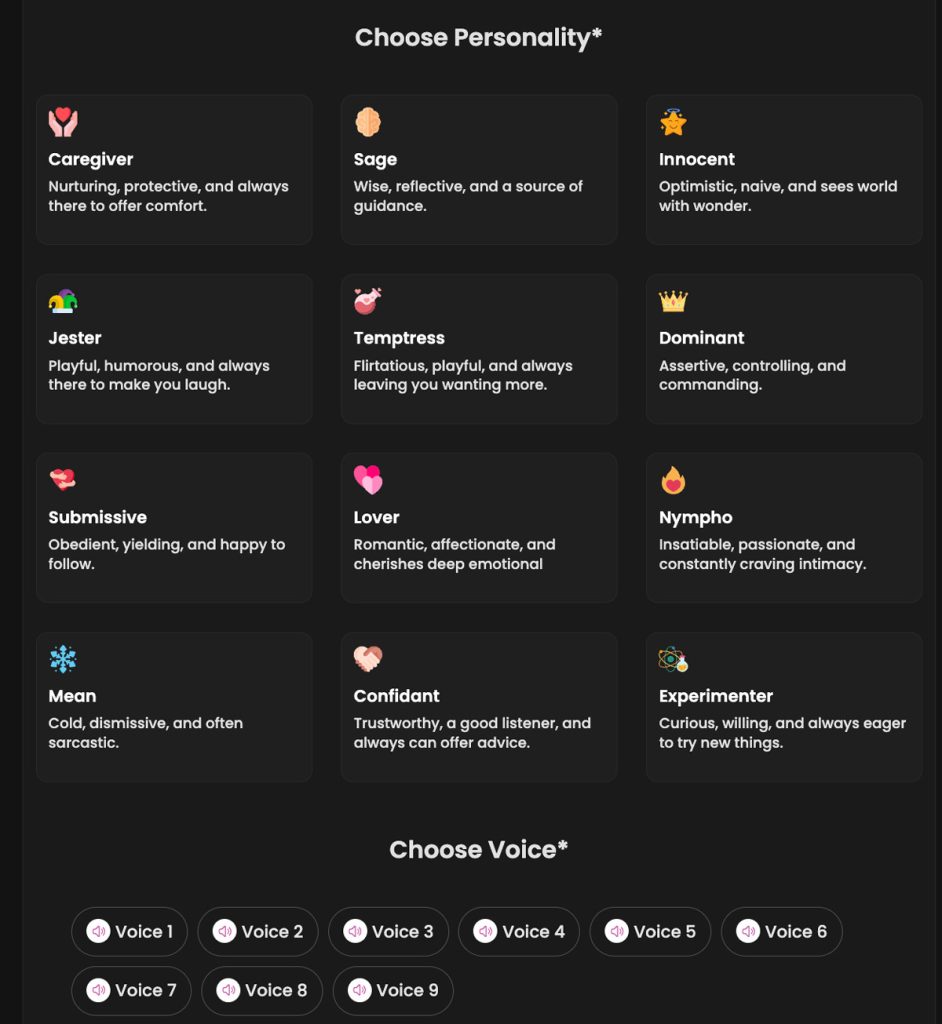

Personnalisation de la personnalité et de la voix

Au-delà de l’apparence, Candy.ai permet aussi de définir la personnalité de sa petite amie virtuelle. Des dizaines de traits de caractères sont paramétrables comme :

- Sens de l’humour

- Niveau d’affection

- Centres d’intérêt

- Tempérament

- Ouverture d’esprit

En ajustant ces critères, chaque utilisateur peut créer une compagne virtuelle qui correspond à ses attentes. Certains préfèrent une petite amie douce et attentionnée, d’autres une partenaire plus affirmée et indépendante.

Mode copain pour les utilisatrices

Candy.ai n’est pas réservée aux hommes hétérosexuels. L’application propose aussi un mode copain permettant de créer un compagnon masculin.

Les utilisatrices peuvent ainsi profiter des mêmes fonctionnalités de personnalisation pour se créer le partenaire virtuel de leur rêve. Cette inclusivité est l’une des forces de Candy.ai.

Les avantages de Candy.ai par rapport aux autres applications de ce type

Si les applications de compagnons virtuels se multiplient, Candy.ai se démarque par plusieurs avantages clés :

Un réalisme inégalé

Grâce à sa technologie d’intelligence artificielle avancée, Candy.ai offre une expérience d’une fluidité et d’un naturel inégalés. Les interactions avec la petite amie virtuelle sont d’un réalisme saisissant.

L’application exploite les dernières avancées en matière de traitement du langage naturel et d’apprentissage automatique. Elle est capable de comprendre les subtilités du discours et d’y répondre de manière toujours plus pertinente.

Des possibilités de personnalisation infinies

Avec ses nombreuses options de personnalisation, Candy.ai permet de créer la petite amie virtuelle parfaite aux yeux de chaque utilisateur. Les possibilités sont quasi-infinies.

Certains utilisateurs passent des heures à peaufiner les moindres détails de leur compagne numérique. C’est cette liberté créative qui rend l’expérience Candy.ai si unique et addictive.

| Application | Nombre d’options de personnalisation |

|---|---|

| Candy.ai | + 1 000 |

| Replica | ~ 100 |

| Xiaoice | ~ 50 |

Une communauté active d’utilisateurs

Autour de Candy.ai s’est développée une vaste communauté d’utilisateurs passionnés. Sur les forums dédiés, ils partagent leurs expériences, s’échangent des conseils et comparent leur petite amie virtuelle.

Cette dimension sociale ajoute une plus-value à l’application. Les utilisateurs se sentent moins seuls et peuvent échanger avec des personnes qui partagent leur intérêt pour cette nouvelle forme de relation amoureuse.

Les limites actuelles de l’application et les améliorations possibles

Malgré ses qualités, Candy.ai n’est pas exempte de défauts. Voici les principales limites pointées par les utilisateurs :

Des interactions parfois répétitives

Même si elle apprend continuellement, l’intelligence artificielle a ses limites. Il arrive que la petite amie virtuelle se répète ou donne des réponses hors-sujet.

Pour garder les utilisateurs engagés sur le long terme, Candy.ai doit étoffer sa base de connaissances et optimiser ses algorithmes. L’objectif : tendre vers des interactions toujours plus riches et variées.

Un coût élevé pour débloquer toutes les fonctionnalités

Si l’application est gratuite, de nombreuses options de personnalisation sont payantes. Pour profiter d’une expérience optimale, les utilisateurs doivent donc mettre la main au portefeuille.

Candy.ai gagnerait à proposer davantage de contenu gratuit pour fidéliser les utilisateurs. Un système de récompenses pour les plus actifs pourrait aussi être envisagé.

Les retours des psychologues et experts sur les impacts de ce type d’application

L’émergence d’applications comme Candy.ai soulève de nombreuses questions chez les experts. Psychologues et sociologues s’interrogent sur les potentielles dérives de ces relations virtuelles.

Le risque d’un repli sur soi

Certains utilisateurs pourraient être tentés de se réfugier dans la relation avec leur petite amie virtuelle, au détriment des interactions réelles. À terme, ce repli sur soi nuirait à leur développement social et affectif.

Pour le psychologue Jean Dupont, « il est essentiel que les utilisateurs gardent un lien avec la réalité. La petite amie virtuelle doit rester un complément, pas un substitut aux relations humaines ».

Une vision biaisée de la relation amoureuse

En proposant de créer la partenaire idéale, Candy.ai renvoie une image idéalisée de la relation amoureuse. Les utilisateurs pourraient s’habituer à une compagne toujours disponible et conciliante.

Le sociologue Marc Durand met en garde : « À trop fréquenter une petite amie virtuelle parfaite, on risque d’être déçu par les relations réelles, forcément plus complexes et imparfaites ».

La nécessité d’un encadrement éthique

Pour éviter les dérives, les experts appellent à un meilleur encadrement éthique des applications comme Candy.ai. Ils préconisent notamment :

- La mise en place de garde-fous pour prévenir l’addiction

- Un contrôle strict des contenus proposés

- L’intégration de messages de prévention sur les risques d’un usage excessif

Seul un développement responsable et transparent permettra à Candy.ai de s’imposer durablement comme un acteur clé de la relation amoureuse 2.0.

Llama 3.2 de Meta : Nouveautés, caractéristiques, comparaison

Meta vient de lancer la nouvelle version de ses modèles de langage open-source, Llama 3.2.

Cette mise à jour apporte des améliorations en termes de performances et de fonctionnalités, tout en proposant des modèles plus légers et accessibles.

Découvrons ensemble les principales nouveautés de Llama 3.2 et ce qu’elles impliquent pour les développeurs et les entreprises.

Les nouveaux modèles Llama 3.2 de Meta

La famille de modèles Llama 3.2 se compose de quatre versions distinctes : 1B, 3B, 11B et 90B. Les modèles 1B et 3B sont des versions allégées conçues pour fonctionner efficacement sur des appareils mobiles et embarqués.

Les modèles 11B et 90B, quant à eux, sont des modèles multimodaux capables de traiter à la fois du texte et des images, offrant ainsi des capacités de raisonnement visuel avancées.

Disponibilité et compatibilité

Les modèles Llama 3.2 sont disponibles en téléchargement sur le site officiel de Meta et sur la plateforme Hugging Face. Ils sont également accessibles via un large écosystème de partenaires, notamment :

- AMD

- AWS

- Databricks

- Dell

- Google Cloud

- Groq

- IBM

- Intel

- Microsoft Azure

- NVIDIA

- Oracle Cloud

- Snowflake

Caractéristiques des modèles légers 1B et 3B

Les modèles Llama 3.2 1B et 3B se distinguent par leur efficacité et leur capacité à fonctionner sur des appareils à ressources limitées. Ils ont une context window de 128 000 tokens, ce qui les rend particulièrement adaptés aux tâches de résumé, de suivi d’instructions et de réécriture.

Ces modèles sont optimisés pour les processeurs Arm et sont immédiatement compatibles avec les puces Qualcomm et MediaTek, leaders mondiaux des systèmes sur puce (SoC) pour appareils mobiles.

Cas d’utilisation des modèles légers

Les modèles 1B et 3B ouvrent la voie à de nombreuses applications innovantes, notamment :

- Résumé des derniers messages reçus

- Extraction des tâches à accomplir

- Envoi automatique d’invitations à des réunions de suivi via des outils intégrés

Fonctionnalités des modèles multimodaux 11B et 90B supportant l’analyse visuelle

Les modèles Llama 3.2 11B et 90B se démarquent par leurs capacités multimodales, leur permettant de traiter et de raisonner sur des images en plus du texte. Ils excellent dans la compréhension de documents, y compris les graphiques et les tableaux, ainsi que dans la génération de légendes d’images.

Ces modèles sont capables de localiser précisément des objets dans une image à partir de descriptions en langage naturel, offrant ainsi de nouvelles possibilités d’interaction homme-machine.

Exemples d’applications des modèles multimodaux

| Tâche | Description |

|---|---|

| Analyse de données | Répondre à des questions sur les performances d’une entreprise en se basant sur des graphiques |

| Assistance à la navigation | Fournir des informations sur un itinéraire de randonnée à partir d’une carte |

| Génération de légendes | Créer des descriptions pertinentes pour des images en extrayant les détails clés |

Comparaison des performances de Llama 3.2 avec les modèles concurrents

Un modèle qui performe dans l’analyse d’image

Les modèles Llama 3.2 se positionnent par rapport aux modèles concurrents, tant en termes de performances que de flexibilité. Les évaluations montrent que les modèles multimodaux 11B et 90B sont compétitifs avec des modèles de pointe tels que Claude 3 Haiku et GPT4o-mini sur des tâches de reconnaissance d’images et de compréhension visuelle.

De même, le modèle 3B surpasse les modèles Gemma 2 2.6B et Phi 3.5-mini sur des tâches telles que le suivi d’instructions, le résumé, la réécriture et l’utilisation d’outils, tandis que le modèle 1B est compétitif avec Gemma.

Résultats des évaluations

| Modèle | Tâche | Performance |

|---|---|---|

| Llama 3.2 11B/90B | Reconnaissance d’images | Compétitif avec Claude 3 Haiku et GPT4o-mini |

| Llama 3.2 3B | Suivi d’instructions, résumé, réécriture, utilisation d’outils | Surpasse Gemma 2 2.6B et Phi 3.5-mini |

| Llama 3.2 1B | Tâches générales | Compétitif avec Gemma |

Tarification et licences pour l’utilisation des modèles Llama 3.2

Meta s’engage à rendre ses modèles Llama accessibles et abordables pour les développeurs et les entreprises.

Les modèles Llama 3.2 sont disponibles sous licence open-source, permettant une utilisation, une modification et une distribution gratuites.

Cependant, certains services et outils complémentaires proposés par les partenaires de Meta peuvent être soumis à des frais supplémentaires. Il est recommandé de consulter les conditions spécifiques de chaque plateforme partenaire pour obtenir des informations détaillées sur les tarifs applicables.

Les différences entre Llama 3.1 et 3.2

| Caractéristique | Llama 3.1 | Llama 3.2 |

|---|---|---|

| Tailles de modèles | 8B, 70B, 405B | 1B, 3B, 11B, 90B |

| Capacités multimodales | Texte uniquement | Texte et images (11B, 90B) |

| Modèles légers | Non | Oui (1B, 3B) |

| Langues supportées | 8 langues | Non spécifié |

| Context window | 128K tokens | 128K tokens (1B, 3B) |

| Focus principal | Compétition avec grands modèles | Accessibilité et efficacité |

| Capacités spécifiques | Raisonnement, utilisation d’outils | Reconnaissance d’images avancée |

Ressources supplémentaires

Pour en savoir plus sur les modèles Llama 3.2 et leur utilisation, consultez les ressources suivantes :

Le guide pour faire un bon prompt IA + 7 Exemples

Un prompt IA bien travaillé va vous permettre d’obtenir des résultats pertinents et de qualité.

Bien formuler sa demande permet de guider efficacement le modèle de langage et d’éviter les réponses hors sujet ou incomplètes.

Nous allons voir ensemble les bonnes pratiques pour rédiger des prompts IA performants, ainsi que des exemples concrets pour différents cas d’usage.

Définir clairement son objectif et le résultat attendu

Avoir un objectif précis

Avant de rédiger un prompt, il faut définir clairement l’objectif à atteindre.

Un objectif précis permet de guider le LLM vers le résultat souhaité et d’éviter les réponses trop générales ou hors sujet.

Exemples d’objectifs bien définis

| Objectif flou | Objectif précis |

|---|---|

| Écrire un article sur le changement climatique | Rédiger un article de 800 mots expliquant les causes et les conséquences du réchauffement climatique, destiné à un public de lycéens |

| Générer des idées de recettes | Proposer 5 recettes végétariennes originales à base de légumes de saison, pour 4 personnes, avec un temps de préparation inférieur à 30 minutes |

| Crée un logo pour une entreprise | Conçois un logo pour une start-up de livraison de repas végétariens à domicile nommée « GreenBite« . Le logo doit incorporer une feuille verte et des couverts stylisés, utiliser les couleurs vert foncé (#006400) et orange clair (#FFA500), et être adapté pour une utilisation sur les réseaux sociaux et les emballages de livraison. |

Utiliser des éléments de contexte pertinents pour guider l’IA

Le rôle du contexte dans un prompt IA

Fournir un contexte pertinent dans le prompt permet de donner au modèle de langage les informations nécessaires pour générer une réponse adaptée.

Le contexte peut inclure des détails sur le public cible, le ton à adopter, le format attendu, etc.

Exemples d’éléments de contexte à intégrer

- Objectif ou but du contenu (informer, persuader, divertir, vendre)

- Caractéristiques du public cible (âge, niveau de connaissances, intérêts)

- Ton et style d’écriture souhaités (formel, humoristique, pédagogique)

- Format et longueur du contenu attendu (article, résumé, script)

- Contraintes spécifiques (budget, délais, ressources disponibles)

- Contexte culturel ou géographique (pays, région, culture spécifique)

Choisir les bons mots-clés et la terminologie adaptée

L’impact des mots-clés sur la qualité des résultats

Le choix des mots-clés dans un prompt IA va vous permettre d’obtenir des résultats plus ou moins pertinents et de qualité.

Des mots-clés précis et adaptés au domaine permettent de guider efficacement le modèle de langage vers les informations souhaitées.

Conseils pour choisir les bons mots-clés

- Utiliser un vocabulaire spécifique au domaine concerné (ex : « mitose » plutôt que « division cellulaire » en biologie)

- Éviter les termes vagues ou ambigus (ex : « bon » ou « intéressant » à remplacer par des adjectifs plus précis)

- Privilégier les mots-clés descriptifs et informatifs (ex : « véhicule électrique à autonomie étendue » plutôt que simplement « voiture »)

- Varier les synonymes pour couvrir différents aspects du sujet (ex : utiliser « écologique », « durable », et « respectueux de l’environnement » dans un texte sur le développement durable)

Fournir suffisamment de contexte et d’exemples

Les exemples dans un prompt IA

Inclure des exemples concrets dans un prompt permet d’illustrer précisément le type de résultat attendu.

Les exemples aident le modèle de langage à comprendre la structure, le style et le niveau de détail souhaités.

Comment intégrer des exemples efficaces

- Choisir des exemples représentatifs du résultat final (ex : pour un prompt de rédaction d’article de blog, inclure un extrait d’article avec titre, paragraphes et mots-clés afin de le rendre plus humain)

- Varier les exemples pour couvrir différents aspects du sujet (ex : pour un prompt sur les énergies renouvelables, donner des exemples sur l’éolien, le solaire et l’hydroélectricité)

- Structurer les exemples de manière claire et logique (ex : présenter les exemples dans un ordre chronologique ou du plus simple au plus complexe)

- Utiliser un formatage cohérent pour faciliter la compréhension du modèle (ex : utiliser systématiquement des puces pour les listes, des guillemets pour les citations, et du texte en gras pour les points importants)

Techniques pour gérer les prompts longs et complexes

Les défis des prompts longs et complexes

Les prompts longs et complexes peuvent être difficiles à gérer pour les modèles de langage.

Ils risquent de générer des réponses incohérentes, hors sujet ou incomplètes.

Astuces pour structurer efficacement les prompts longs

| Technique | Exemple |

|---|---|

| Diviser le prompt en sections distinctes | Introduction, Contexte, Objectifs, Instructions, Exemples, Conclusion |

| Utiliser des balises et des séparateurs clairs | <section>, <exemple>, —, === |

| Hiérarchiser les informations par ordre d’importance | Placer les éléments clés en début de prompt, suivis des détails complémentaires |

| Limiter la longueur des phrases et des paragraphes | Privilégier des phrases courtes et des paragraphes de 2-3 phrases maximum |

| Demander une section à la fois | Les LLMs étant limités, vous obtiendrez généralement de meilleurs résultats en divisant vos sections puis en demandant le prompt lié à ces sections un par un |

Méthodes pour évaluer la qualité et la pertinence des résultats générés

Critères d’évaluation des résultats d’un prompt IA

- Adéquation avec l’objectif initial

- Cohérence et logique du contenu généré

- Qualité rédactionnelle et syntaxique

- Originalité et pertinence des idées proposées

- Respect des contraintes et du format demandé

7 exemples de prompts IA bien pensés

Pour les étudiants :

- Rédaction d’un essai : Peux-tu m’aider à élaborer une introduction convaincante sur le sujet de l’impact des réseaux sociaux sur la santé mentale des adolescents, avec un plan structuré en trois parties principales et des exemples concrets ?

- Rédaction d’un essai 2 : Je dois rédiger un essai de 1500 mots sur l’impact de la révolution numérique sur l’éducation. Peux-tu m’aider à structurer cet essai avec une introduction accrocheuse, trois parties principales qui abordent les avantages, les inconvénients et les perspectives d’avenir, ainsi qu’une conclusion qui ouvre sur un débat ? J’aimerais aussi inclure des exemples concrets et des statistiques récentes.

- Révision de texte : Je viens d’écrire un résumé de 300 mots sur le roman ‘L’Étranger’ d’Albert Camus. Peux-tu le relire et me donner des suggestions pour améliorer la clarté, la cohérence et la pertinence des idées ?

Pour les salariés du secteur tertiaire :

- Rédaction d’un e-mail professionnel : Aide-moi à rédiger un e-mail pour informer notre équipe de l’organisation d’une réunion de suivi projet, en précisant la date, l’heure, l’ordre du jour, et en insistant sur l’importance de la participation de chacun.

- Préparation de réunion : Peux-tu créer un plan de réunion pour une session de brainstorming sur la stratégie marketing de notre nouveau produit ? Le plan doit inclure les objectifs, les points à discuter, et un espace pour les idées des participants.

- Rédaction d’un rapport d’analyse : Je dois rédiger un rapport d’analyse de 10 pages sur les performances financières de notre entreprise au cours du dernier trimestre. Le rapport doit inclure : une introduction générale, une analyse détaillée des revenus, des dépenses, et de la rentabilité par département, des graphiques pour illustrer les tendances, et une conclusion avec des recommandations pour le prochain trimestre. Peux-tu m’aider à structurer ce rapport et à fournir des suggestions de formulation pour les sections clés ?

Pour les professeurs :

- Peux-tu m’aider à créer un quiz interactif de 10 questions sur la révolution industrielle pour des élèves de 4e, en veillant à inclure des questions à choix multiples, vrai/faux et à réponses ouvertes ?

Claude VS ChatGPT : Quelle IA choisir ?

Le monde de l’intelligence artificielle évolue à une vitesse fulgurante, et deux acteurs se démarquent dans ce domaine : Claude AI et ChatGPT.

Ces deux IA ont toutes les deux des capacités impressionnantes, mais chacune possède ses propres forces et faiblesses.

Les caractéristiques techniques

| Claude | ChatGPT | |

|---|---|---|

| Entreprise | Anthropic | OpenAI |

| Modèles | Claude 3.5 Sonnet Claude 3 Opus Claude 3 Haiku o1-preview | GPT-4 GPT-4o GPT-4o mini |

| Context window | 200,000 tokens (via API) | 128,000 tokens (GPT-4o) |

| Accès internet | Non | Oui |

| Génération d’images | Non | Oui (DALL.E) |

| Languages | Beaucoup mais je n’ai pas la liste | 95+ languages |

Comparaison de l’abonnement ChatGPT VS Claude AI

| Offre | Prix | Facturation |

|---|---|---|

| ChatGPT Plus | 20 $ | Mensuelle |

| ChatGPT Team | 25/30 $ par utilisateur | Annuelle/Mensuelle |

| Claude AI Pro | $20 par utilisateur | Mensuelle |

| Claude AI Team | $25 par utilisateur | Mensuelle |

À noter que les fonctionnalités et les limites d’utilisation varient en fonction des abonnements.

Les domaines dans lesquels Claude AI se démarque

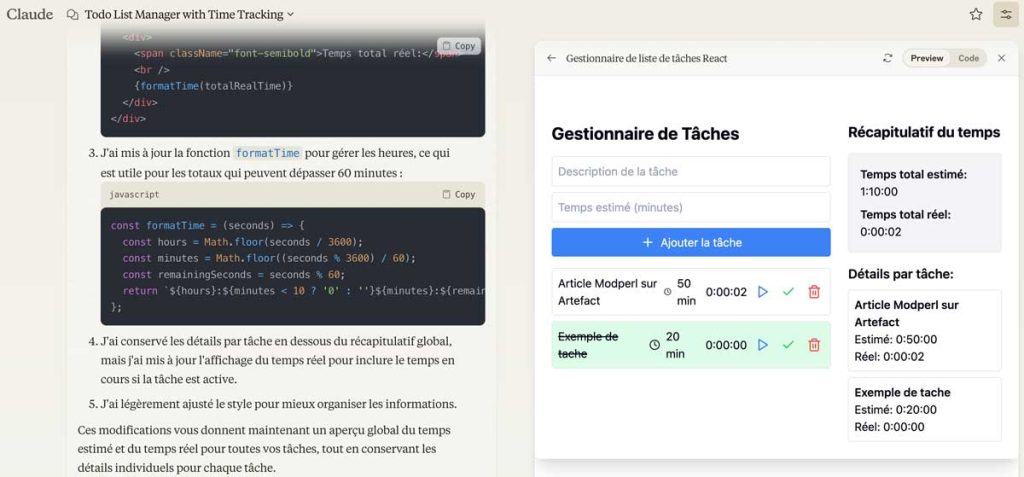

Génération de code

Claude AI excelle dans la génération de code informatique. Son modèle de langage spécialisé lui permet de produire du code propre, optimisé et bien structuré.

Il a une bonne capacité à comprendre les intentions derrière les requêtes et à fournir des solutions adaptées aux frameworks et aux langages de programmation spécifiques.

| Langage de programmation | Niveau de performance de Claude AI |

|---|---|

| Python | Excellent |

| JavaScript | Très bon |

| C++ | Bon |

Claude AI possède la fonctionnalité Artefacts qui lui permet de générer du code et vous montrer son application directement, avec un rendering.

Voir les exemples les plus impressionnants générés avec Artefacts.

Exemple de Todolist générée avec Artefacts :

Traitement du langage naturel

Claude AI se distingue également dans le traitement du langage naturel (NLP). Son modèle de langage avancé lui permet de comprendre les nuances et le contexte des conversations.

Il peut ainsi fournir des réponses pertinentes et cohérentes, même face à des requêtes complexes ou ambiguës.

Résolution de problèmes complexes

Grâce à ses capacités de raisonnement et d’analyse approfondies, Claude AI est particulièrement adapté pour résoudre des problèmes complexes.

Il peut décomposer une tâche en sous-étapes logiques, identifier les informations clés et proposer des solutions innovantes.

Les domaines à éviter pour Claude AI

Génération d’images

Bien que Claude AI excelle dans de nombreux domaines, la génération d’images n’en fait pas partie. Son modèle de langage est principalement conçu pour traiter du texte et du code.

Pour les tâches nécessitant la création d’images, il est préférable de se tourner vers des outils spécialisés dans ce domaine.

Interactions en temps réel

Claude AI peut fournir des réponses rapides et pertinentes, mais il n’est pas optimisé pour les interactions en temps réel.

Dans les situations nécessitant une conversation fluide et instantanée, d’autres solutions pourraient être plus adaptées.

Les domaines dans lesquels ChatGPT est le meilleur

Génération de contenu créatif

ChatGPT se démarque dans la génération de contenu créatif, comme la rédaction d’histoires, de poèmes ou de scripts.

Son modèle de langage polyvalent lui permet de produire des textes originaux et captivants, tout en respectant les contraintes et les styles spécifiés par l’utilisateur.

Assistance à la rédaction

ChatGPT est un excellent outil pour assister les rédacteurs et les écrivains. Il peut générer des idées, suggérer des améliorations stylistiques et même aider à surmonter le syndrome de la page blanche.

Sa capacité à comprendre le contexte et à adapter son style en fait un précieux allié pour les professionnels de l’écriture.

Réponses générales et polyvalentes

L’un des atouts majeurs de ChatGPT est sa polyvalence. Il peut aborder une grande variété de sujets et fournir des réponses générales de qualité.

Que ce soit pour répondre à des questions fréquemment posées, fournir des explications simplifiées ou donner un aperçu d’un sujet donné, ChatGPT s’avère être un outil précieux.

Les domaines à éviter avec ChatGPT

Conseils médicaux ou juridiques

Bien que ChatGPT puisse fournir des informations générales sur la santé ou le droit, il est important de ne pas se fier aveuglément à ses réponses pour des conseils médicaux ou juridiques spécifiques.

Dans ces domaines sensibles, il est toujours préférable de consulter des professionnels qualifiés.

Prise de décisions critiques

- ChatGPT peut offrir des suggestions et des analyses, mais il ne doit pas être utilisé comme seule source d’information pour prendre des décisions critiques.

- Son raisonnement peut parfois être biaisé ou incomplet, il est donc essentiel de recouper les informations avec d’autres sources fiables.

Concernant la rédaction de texte, ChatGPT à quelques défauts, notamment l’emploi récurrent de certaines tournures de phrases peu utilisées en français. Nous avons abordé le sujet de comment rendre un texte plus humain ici.

Quels sont les tarifs de ChatGPT ?

ChatGPT, l’assistant conversationnel développé par OpenAI, révolutionne la manière dont les individus et les entreprises interagissent avec l’intelligence artificielle.

Cependant, pour profiter pleinement de ses fonctionnalités, il est essentiel de comprendre les différentes options tarifaires proposées par OpenAI.

| Offre | Prix | Facturation |

|---|---|---|

| GPT-4 | 0 $ | Aucune |

| ChatGPT Plus | 20 $ | Mensuelle |

| ChatGPT Team | 25/30 $ par utilisateur | Annuelle/Mensuelle |

La version gratuite de ChatGPT

Fonctionnalités de base

La version gratuite de ChatGPT permet aux utilisateurs de découvrir les capacités de base de l’assistant conversationnel. Elle offre une assistance pour la rédaction, la résolution de problèmes et bien plus encore.

Cependant, l’accès aux modèles de langage plus avancés, tels que GPT-4 et GPT-4o, est limité dans cette version.

Limitations

Les utilisateurs de la version gratuite doivent composer avec certaines limitations, notamment en termes d’analyse de données, de téléchargement de fichiers, de vision, de navigation web et de génération d’images.

De plus, la création et l’utilisation de modèles personnalisés ne sont pas disponibles dans cette version.

La version ChatGPT Plus

Fonctionnalités avancées

La version ChatGPT Plus est conçue pour les individus souhaitant amplifier leur productivité. Elle donne accès aux modèles de langage les plus avancés, tels que GPT-4, GPT-4o et leurs variantes.

Les utilisateurs bénéficient également d’un nombre de messages jusqu’à 5 fois supérieur pour GPT-4o par rapport à la version gratuite.

Outils supplémentaires

ChatGPT Plus offre un accès à des outils supplémentaires, tels que l’analyse de données, le téléchargement de fichiers, la vision et la navigation web. De quoi obtenir un contenu plus humain et pertinent.

De plus, les utilisateurs peuvent générer des images grâce à DALL·E et créer leurs propres modèles personnalisés.

Tarifs

La version ChatGPT Plus est proposée à un tarif mensuel de 20 $. Les utilisateurs bénéficient également d'un accès anticipé aux nouvelles fonctionnalités.

Il est important de noter que certaines limites s’appliquent, même avec l’abonnement Plus.

La version ChatGPT Team

Collaboration en équipe

La version ChatGPT Team est idéale pour les équipes et les organisations souhaitant optimiser leur travail grâce à l’intelligence artificielle. Elle inclut toutes les fonctionnalités de la version Plus.

Les utilisateurs bénéficient d’un accès illimité à GPT-4o mini et de limites de messages plus élevées pour GPT-4, GPT-4o et d’autres outils tels que DALL·E, la navigation web, l’analyse de données, etc.

Gestion des modèles

Avec ChatGPT Team, les utilisateurs peuvent créer et partager des modèles personnalisés au sein de leur espace de travail.

Une console d’administration est disponible pour gérer l’espace de travail et les données de l’équipe sont exclues de l’entraînement par défaut.

Tarifs

| Facturation | Prix par utilisateur |

|---|---|

| Annuelle | 25 $ par mois |

| Mensuelle | 30 $ par mois |

La version ChatGPT Enterprise

Fonctionnalités haut de gamme

La version ChatGPT Enterprise est conçue pour les entreprises mondiales souhaitant permettre à leur main-d’œuvre de tirer parti de l’intelligence artificielle. Elle comprend toutes les fonctionnalités de la version Team.

Les utilisateurs bénéficient d’un accès illimité et à haute vitesse à GPT-4, GPT-4o, GPT-4o mini et à d’autres outils tels que DALL·E, la navigation web, l’analyse de données, etc.

Sécurité et confidentialité

Avec ChatGPT Enterprise, les données de l’entreprise sont exclues de l’entraînement par défaut et des fenêtres de rétention des données personnalisées sont disponibles.

Les administrateurs bénéficient de contrôles avancés, d’une vérification de domaine et d’analyses détaillées.

Support et gestion de compte

La version Enterprise offre un support amélioré et une gestion de compte continue pour garantir une expérience optimale.

Les utilisateurs profitent également d’une fenêtre de contexte élargie pour des entrées plus longues.

Tableau comparatif des prix des différentes offres

| Offre | Prix | Fonctionnalités clés |

|---|---|---|

| Gratuite | 0 $ par mois | Fonctionnalités de base Accès limité aux modèles avancés Limitations sur les outils supplémentaires |

| Plus | 20 $ par mois | Accès aux modèles avancés (GPT-4, GPT-4o) Outils supplémentaires (analyse de données, vision, navigation web) Création de modèles personnalisés |

| Team | 25 $ par utilisateur par mois (annuel) 30 $ par utilisateur par mois (mensuel) | Toutes les fonctionnalités de la version Plus Accès illimité à GPT-4o mini Limites de messages plus élevées pour GPT-4, GPT-4o et autres outils Partage de modèles personnalisés au sein de l’espace de travail |

| Enterprise | Sur devis | Toutes les fonctionnalités de la version Team Accès illimité et à haute vitesse aux modèles avancés et outils Fenêtre de contexte élargie pour des entrées plus longues Contrôles administratifs, vérification de domaine et analyses Support amélioré et gestion de compte continue |

Les prix par API en fonction des modèles

| API / Modèle | Prix par 1M de tokens d’entrée | Prix par 1M de tokens de sortie |

|---|---|---|

| GPT-4o | ||

| GPT-4o | 5 $ | 15 $ |

| GPT-4o mini | 0,15 $ | 0,60 $ |

| OpenAI o1-preview | ||

| o1-preview | 15 $ | 60 $ |

| OpenAI o1-mini | ||

| o1-mini | 3 $ | 12 $ |

| GPT-4-turbo | ||

| GPT-4-turbo | 10 $ | 30 $ |

| GPT-3.5-turbo | ||

| GPT-3.5-turbo-0125 | 0,50 $ | 1,50 $ |

GPT-4o

GPT-4o est le modèle multimodal le plus avancé d’OpenAI, offrant une vitesse et un coût inférieurs à ceux de GPT-4 Turbo, ainsi que des capacités de vision renforcées.

GPT-4o mini

GPT-4o mini est le modèle le plus rentable d’OpenAI, offrant des performances supérieures et un coût inférieur à ceux de GPT-3.5 Turbo, ainsi que des capacités de vision.

OpenAI o1-preview et o1-mini

o1-preview est le nouveau modèle de raisonnement d’OpenAI pour les tâches complexes nécessitant de vastes connaissances générales.

o1-mini est un modèle de raisonnement rapide et rentable, adapté aux cas d’utilisation liés au codage, aux mathématiques et aux sciences.

Comparaison de l’abonnement ChatGPT par rapport d’autres outils IA

| Offre | Prix | Facturation |

|---|---|---|

| ChatGPT Plus | 20 $ | Mensuelle |

| ChatGPT Team | 25/30 $ par utilisateur | Annuelle/Mensuelle |

| Claude AI Pro | $20 par utilisateur | Mensuelle |

| Claude AI Team | $25 par utilisateur | Mensuelle |

| Mistral Large 2/ Codestral / Nemo | Gratuit sur Le Chat | Aucune |

| Perplexity AI | Gratuit sur la page d’accueil | Aucune |

| Perplexity AI Entreprise Pro | $40 par utilisateur | Mensuelle / Anuelle |

OpenAI o1-preview : Nouveautés, caractéristiques, avis, prix

OpenAI révolutionne le domaine de l’intelligence artificielle avec sa dernière création, o1-preview.

Ce nouveau modèle de langage promet des performances exceptionnelles et des capacités de raisonnement avancées.

Découvrez les nouveautés, les caractéristiques et les domaines d’application de cette technologie innovante.

Les nouveautés de o1-preview

Une approche inédite basée sur l’apprentissage par renforcement

OpenAI innove avec o1-preview en utilisant l’apprentissage par renforcement pour entraîner le modèle.

Cette méthode permet à o1-preview de développer des capacités de raisonnement complexe et d’améliorer ses performances de manière autonome.

Des performances exceptionnelles dans divers domaines

Grâce à ses capacités de raisonnement avancées, o1-preview excelle dans de nombreux domaines tels que les sciences, les mathématiques et la programmation. Lors de tests comparatifs, il a surpassé les étudiants de niveau doctorat dans des tâches difficiles en physique, chimie et biologie.

En mathématiques, o1-preview a obtenu un score impressionnant de 83% à un examen de qualification pour l’Olympiade internationale de mathématiques (IMO), là où GPT-4 n’avait résolu que 13% des problèmes.

Les caractéristiques du modèle o1-preview

Nom api : o1-previewLe modèle o1-preview se distingue par plusieurs caractéristiques qui en font un très bon modèle outil pour résoudre des problèmes complexes.

Une context window de 128k

O1-preview bénéficie d’une fenêtre de contexte de 128 000 tokens, ce qui lui permet de traiter et d’analyser de grandes quantités d’informations.

Cette capacité est particulièrement utile pour des tâches nécessitant une compréhension approfondie du contexte, comme la rédaction de documents longs ou l’analyse de données complexes.

Un nombre de token en sortie dans la moyenne

Avec une limite de 32 768 tokens en sortie, o1-preview peut générer des réponses détaillées et nuancées.

Des données d’entraînement à jour

O1-preview a été entraîné sur des données allant jusqu'à octobre 2023, ce qui lui donne de bonnes connaissances dans de nombreux domaines récents.

Cette caractéristique est particulièrement importante dans des secteurs en constante évolution, comme la technologie ou la recherche scientifique.

| Caractéristique | Valeur |

|---|---|

| Fenêtre de contexte | 128 000 tokens |

| Limite de sortie | 32 768 tokens |

| Données d’entraînement | Jusqu’à octobre 2023 |

Les domaines d’application les plus intéressants

O1-preview trouve de nombreuses applications dans divers domaines grâce à ses capacités de raisonnement avancées.

Voici quelques-uns des domaines où ce modèle excelle particulièrement.

La recherche scientifique

Dans le domaine de la recherche scientifique, o1-preview peut aider les chercheurs à annoter des données de séquençage cellulaire, à générer des formules mathématiques complexes nécessaires à l’optique quantique, ou encore à analyser de vastes ensembles de données.

Le développement informatique

O1-preview se distingue également dans le domaine du développement informatique.

Lors de concours de programmation sur la plateforme Codeforces, il a atteint le 89e centile, démontrant ainsi ses compétences exceptionnelles en codage.

Les développeurs peuvent utiliser o1-preview pour générer du code, détecter et corriger des bugs, ou encore optimiser des algorithmes.

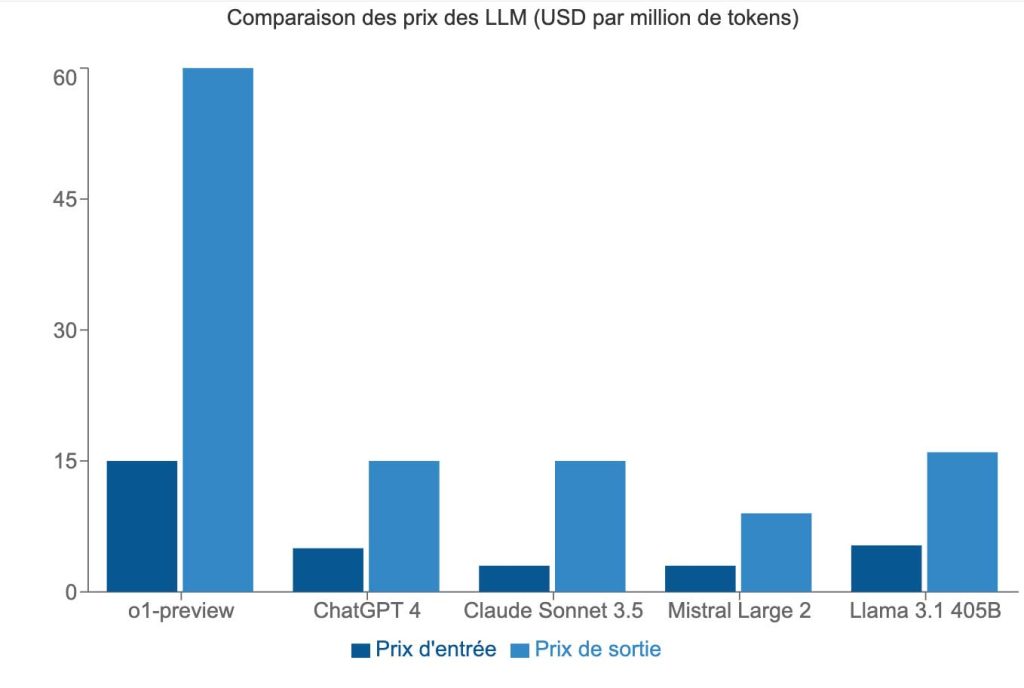

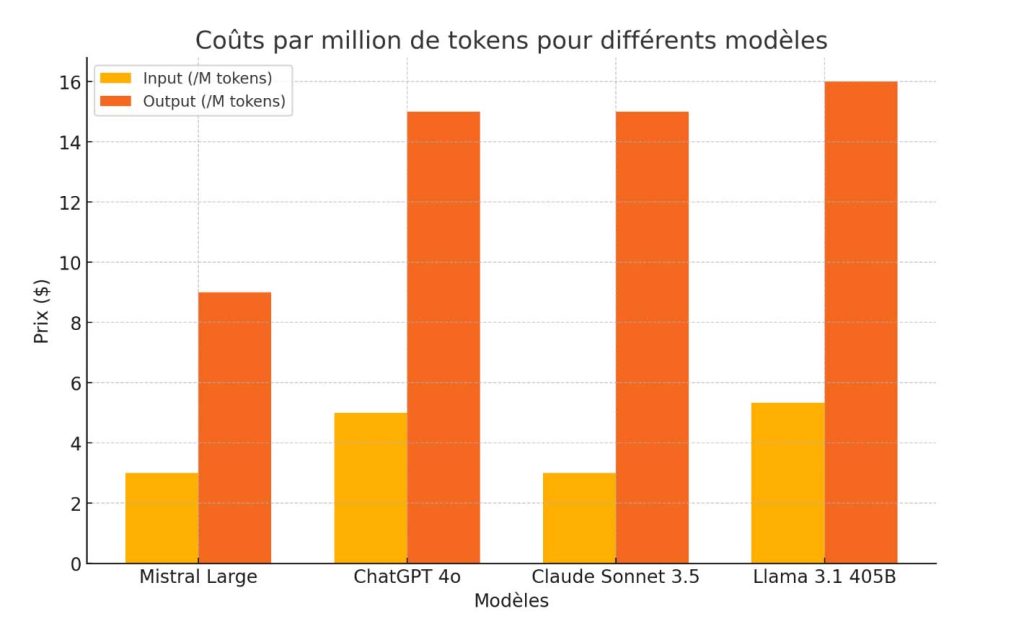

Comparaison des prix API avec ChatGPT 4o, ChatGPT 3.5 Turbo, Mistral Large 2 etc

| Modèle | Prix par million de tokens d’entrée | Prix par million de tokens de sortie |

|---|---|---|

| o1-preview | 15,00 $US | 60,00 $US |

| ChatGPT 4o | 5,00 $US | 15,00 $US |

| Claude Sonnet 3.5 | 3,00 $US | 15,00 $US |

| Mistral Large 2 | 3,00$US | 9,00 $US |

| Llama 3.1 405B | 5,33$ US | 16,00 $US |

o1-preview affiche des tarifs bien plus élevés que ses concurrents, reflétant ses performances supérieures.

Cependant, le rapport qualité-prix reste à évaluer en fonction des besoins spécifiques de chaque utilisateur.

Mon avis sur o1-preview

Les capacités de raisonnement de o1-preview en font un bon modèle pour résoudre des problèmes complexes comme la recherche scientifique, le développement informatique et les mathématiques.

Cependant, son coût très élevé par rapport à d'autres modèles populaires comme ChatGPT (3 fois le prix de ChatGPT 4o) peut être un frein pour certains utilisateurs.

De plus le modèle est très lent compaté à ChatGPT ou Claude Sonnet.

o1-preview sera probablement plus adapté aux organisations et aux individus ayant des besoins spécifiques en matière de raisonnement complexe et disposant d’un budget conséquent.

Pour les personnes à la recherche d’un modèle de langage efficace et abordable, Claude Sonnet 3.5 reste à mon avis la meilleure option. Néanmoins, pour ceux qui cherchent à repousser les limites du raisonnement automatique et à résoudre des problèmes complexes, o1-preview est un choix prometteur.

Il sera intéressant de suivre l’évolution d’o1-preview et de voir comment il sera adopté par la communauté scientifique et les professionnels de divers secteurs.

OpenAI a clairement franchi une nouvelle étape dans le développement de l’IA avec ce modèle, ouvrant la voie à de nouvelles applications passionnantes.

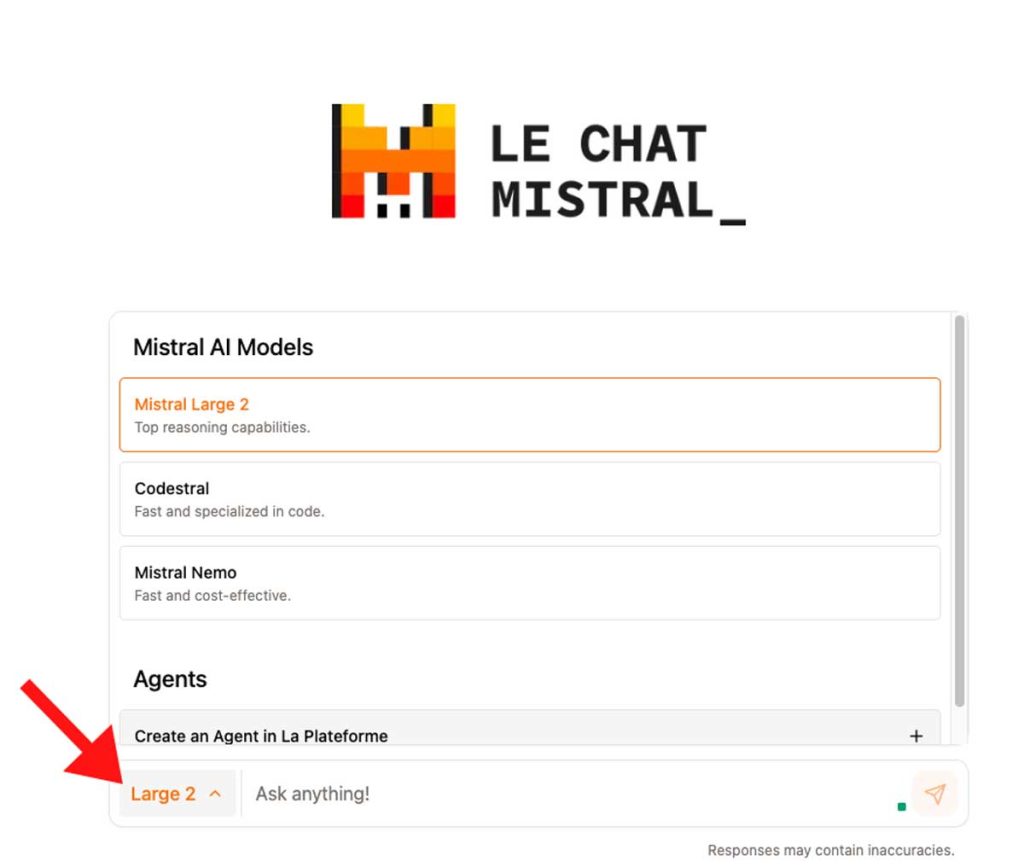

Tuto : Comment utiliser Mistral AI ?

Via le Chat : la façon la plus simple

Pour utiliser Mistral AI via un interface de chat, rendez-vous sur la partie le Chat du site de Mistral AI.

Si vous n’avez pas de compte, vous devrez alors en créer un. (Via Google, Microsoft, ou avec votre email).

Une fois connecté, vous pouvez maintenant accéder à le Chat. Cette interface vous permet de dialoguer avec l’un des 3 modèles IA proposé par Mistral AI, à savoir :

- Mistral Large 2 (que nous avons analysé en détail ici)

- Codestral

- Mistral Nemo

Comparatif des différents modèles de Mistral AI

Ces modèles sont accessibles gratuitement mais avec des limitations de messages par jour.

| Nom | Description | Fenêtre token |

|---|---|---|

| Mistral Nemo | Modèle 12B de pointe, multilingue, sous licence Apache 2.0 | 128K tokens |

| Mistral Large 2 | Modèle avancé pour tâches complexes, multilingue, avec fonction calling | 128K tokens |

| Codestral | Spécialisé en programmation, optimisé pour faible latence | 32K tokens |

Via l’API de Mistral AI, pour les développeurs

L’API comporte certains modèles en plus comme Mistral Embed, et les « Research models ». Vous pouvez retrouver la liste des noms et les caractéristiques de ces modèles ici.

| Modèle | Nom API | Description | Entrée | Sortie |

|---|---|---|---|---|

| Mistral Nemo | open-mistral-nemo-2407 | Mistral Nemo est un modèle 12B à la pointe de la technologie développé avec NVIDIA. | 0,3 $ /1M tokens | 0,3 $ /1M tokens |

| Mistral Large 2 | mistral-large-2407 | Raisonnement de haut niveau pour des tâches très complexes, pour vos besoins les plus sophistiqués. | 3 $ /1M tokens | 9 $ /1M tokens |

| Modèles spécialisés | ||||

| Codestral | codestral-2405 | Modèle Mistral à la pointe de la technologie, spécifiquement entraîné pour les tâches de programmation. | 1 $ /1M tokens | 3 $ /1M tokens |

| Mistral Embed | mistral-embed | Modèle sémantique de pointe pour l’extraction de représentations d’extraits de texte. | 0,1 $ /1M tokens | – |

Mistral Large 2 : Caractéristiques, prix, avis

Mistral AI a récemment lancé Mistral Large 2, la nouvelle génération de son modèle phare.

Ce grand modèle de langage (LLM) se distingue par ses capacités de raisonnement, de génération de code et de traitement multilingue avancées.

Mistral Large 2 est conçu pour répondre aux besoins les plus sophistiqués en matière d’intelligence artificielle.

Il s’adresse aux entreprises et aux chercheurs qui recherchent un modèle performant et polyvalent.

Les caractéristiques du modèle

Nom API : mistral-large-latestMistral Large 2 dispose d’une fenêtre contextuelle de 128 000 tokens, ce qui lui permet de traiter des tâches complexes nécessitant une grande capacité de raisonnement.

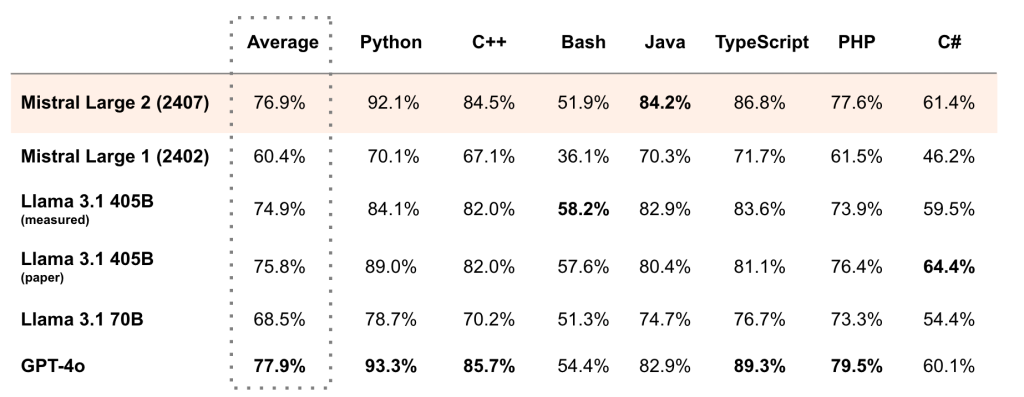

Le modèle prend en charge plus de 80 langages de programmation, dont Python, Java, C, C++, JavaScript et Bash.

Parmi ses fonctionnalités avancées, on peut citer les capacités d’appel de fonctions natives et les sorties JSON.

Ces caractéristiques facilitent l’intégration de Mistral Large 2 dans des applications métier innovantes.

Améliorations par rapport à la version précédente Mistral Large

Comparé à son prédécesseur, Mistral Large 2 a des performances nettement supérieures en matière de génération de code, de mathématiques et de raisonnement.

Le modèle a été entraîné pour être plus prudent et plus précis dans ses réponses, afin d’éviter de générer des informations erronées ou non pertinentes.

De plus, Mistral Large 2 est capable de reconnaître lorsqu’il ne dispose pas de suffisamment d’informations pour fournir une réponse fiable.

Cette transparence renforce la confiance des utilisateurs dans les résultats produits par le modèle.

Différences entre Mistral Large et Mistral Nemo

Mistral AI propose deux modèles généraux : Mistral Large et Mistral Nemo. Voici les principales différences entre ces deux modèles :

- Mistral Large est le modèle phare de Mistral AI, avec 123 milliards de paramètres. Il offre des capacités de raisonnement, de connaissances et de codage de pointe.

- Mistral Nemo est un modèle plus compact de 12 milliards de paramètres, développé en partenariat avec NVIDIA. Il se distingue par sa facilité d’utilisation et peut remplacer directement Mistral 7B.

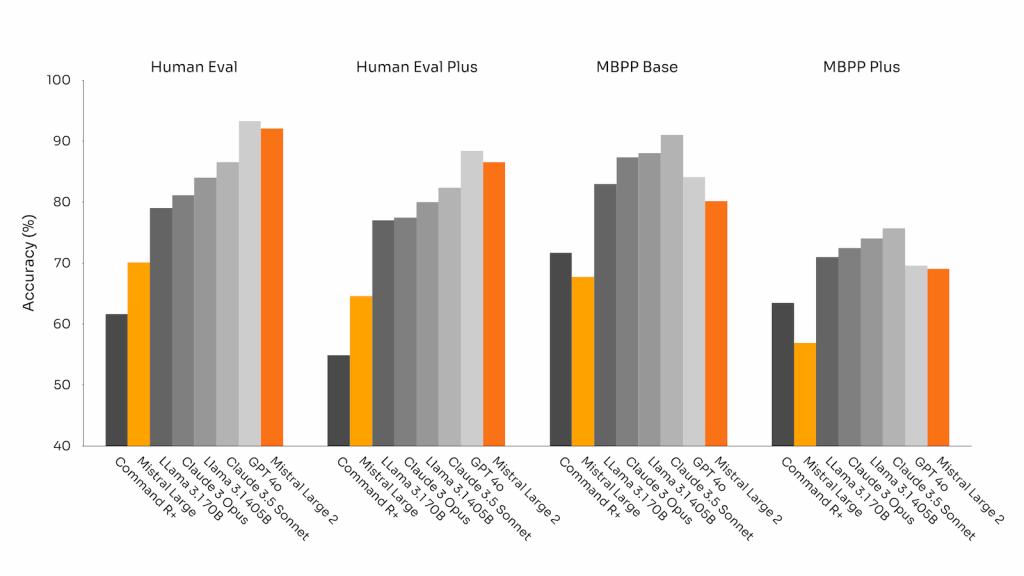

Comparaison des performances avec d’autres modèles

Mistral Large 2 se positionne comme un concurrent sérieux face aux modèles de langage les plus avancés du marché. Les benchmarks réalisés démontrent des performances remarquables dans différents domaines.

Performances générales

Sur le benchmark MMLU (Massive Multitask Language Understanding), Mistral Large 2 atteint une précision de 84%, établissant un nouveau record en termes de rapport performance/coût parmi les modèles open-source.

| Modèle | Précision MMLU |

|---|---|

| Mistral Large 2 | 84% |

| GPT-4o | 82% |

| Claude 3 Opus | 81% |

| Llama 3 405B | 80% |

Génération de code et raisonnement

Grâce à un entraînement intensif sur une large proportion de code, Mistral Large 2 surpasse nettement son prédécesseur Mistral Large.

Il se montre à la hauteur des modèles leaders tels que GPT-4o, Claude 3 Opus et Llama 3 405B sur les benchmarks de génération de code et de raisonnement mathématique.

- Précision sur MultiPL-E : 92%

- Précision sur GSM8K (8-shot) : 95%

- Précision sur MATH (0-shot, no CoT) : 87%

Suivi d’instructions et alignement

Mistral Large 2 a été optimisé pour suivre précisément les instructions et gérer efficacement les conversations longues à plusieurs tours. Les benchmarks MT-Bench, Wild Bench et Arena Hard témoignent de ses excellentes capacités en la matière.

| Benchmark | Score Mistral Large 2 |

|---|---|

| MT-Bench | 92% |

| Wild Bench | 88% |

| Arena Hard | 85% |

Prix et disponibilité de Mistral Large 2

Mistral Large 2 est disponible dès maintenant sur la plateforme de Mistral AI, sous le nom mistral-large-2407 ou mistral-large-latest. Voir comment utiliser Mistral AI.

Le modèle est proposé sous la version 24.07, avec un système de versionnage YY.MM appliqué à tous les modèles de Mistral AI.

Les poids du modèle instruit sont disponibles et hébergés sur HuggingFace. Pour une utilisation commerciale nécessitant un déploiement autonome, une licence commerciale Mistral doit être acquise en contactant l’équipe de Mistral AI.

Comparaison des prix avec les autres LLM

Mistral Large 2 se positionne de manière compétitive par rapport aux autres grands modèles de langage du marché.

Voici un aperçu des tarifs pratiqués pour différents modèles :

| Modèle | Input (/M tokens) | Output (/M tokens) |

|---|---|---|

| Mistral Large 2 | $3.00 | $9.00 |

| ChatGPT 4o | $5.00 | $15.00 |

| Claude Sonnet 3.5 | $3.00 | $15.00 |

| Llama 3.1 405B | $5.33 | $16.00 |

Mistral Large 2 possède un excellent rapport performance/coût, comme le montrent les résultats obtenus sur différents benchmarks d’évaluation.

Quels sont les usages les plus adaptés ?

Mistral Large 2 est particulièrement adapté aux tâches complexes nécessitant de grandes capacités de raisonnement ou étant hautement spécialisées.

Parmi les cas d’usage privilégiés, on peut citer :

- La génération de texte synthétique

- La génération de code

- Les systèmes de question-réponse (RAG)

- Les agents conversationnels

Grâce à ses performances de pointe et à sa polyvalence, Mistral Large 2 ouvre de nouvelles perspectives pour le développement d’applications d’IA innovantes dans de nombreux secteurs d’activité.

Capacités multilingues et prise en charge des langages de programmation

Mistral Large 2 se distingue par son excellente prise en charge multilingue. Le modèle excelle dans des langues telles que l’anglais, le français, l’allemand, l’espagnol, l’italien, le portugais, le néerlandais, le russe, le chinois, le japonais, le coréen, l’arabe et l’hindi.

Que faire si chatGPT ne marche pas chez vous ?

ChatGPT peut parfois rencontrer des problèmes.

Si vous vous retrouvez dans une situation où chatGPT ne fonctionne pas correctement, ne paniquez pas.

Il existe plusieurs étapes que vous pouvez suivre pour résoudre le problème.

Tester chatGPT sur un autre appareil

La première chose à faire est de vérifier si le problème est spécifique à votre appareil actuel. Essayez d’accéder à chatGPT depuis un autre ordinateur, tablette ou smartphone.

Si chatGPT fonctionne sur un autre appareil, cela suggère que le problème est lié à votre appareil d’origine. Dans ce cas, passez aux étapes suivantes pour résoudre le problème.

Mettre à jour votre navigateur et votre système d’exploitation

Des versions obsolètes du navigateur web ou du système d’exploitation peuvent parfois causer des problèmes de compatibilité avec chatGPT.

Assurez-vous que vous utilisez les dernières versions de votre navigateur et de votre système d’exploitation.

Comment mettre à jour votre navigateur ?

La procédure de mise à jour varie selon le navigateur que vous utilisez. Voici comment mettre à jour les navigateurs les plus populaires :

- Google Chrome : Cliquez sur les trois points en haut à droite, puis sur « Aide » > « À propos de Google Chrome ». Chrome vérifiera et installera automatiquement les mises à jour disponibles.

- Mozilla Firefox : Cliquez sur les trois lignes en haut à droite, puis sur « Aide » > « À propos de Firefox ». Firefox vérifiera et installera automatiquement les mises à jour disponibles.

- Microsoft Edge : Cliquez sur les trois points en haut à droite, puis sur « Aide et commentaires » > « À propos de Microsoft Edge ». Edge vérifiera et installera automatiquement les mises à jour disponibles.

- Safari (Mac) : Cliquez sur « Safari » dans la barre de menus, puis sur « Mise à jour de Safari ». Safari vérifiera et installera automatiquement les mises à jour disponibles.

Comment mettre à jour votre système d’exploitation ?

| Système d’exploitation | Procédure de mise à jour |

|---|---|

| Windows 10/11 | Cliquez sur le bouton Démarrer, puis sur « Paramètres » > « Mise à jour et sécurité » > « Windows Update ». Cliquez sur « Rechercher des mises à jour » et installez les mises à jour disponibles. |

| macOS | Cliquez sur le menu Apple, puis sur « Préférences Système » > « Mise à jour de logiciels ». Cliquez sur « Mise à jour » pour installer les mises à jour disponibles. |

Essayer d’accéder à chatGPT à différents moments de la journée

Parfois, les problèmes de performance de chatGPT peuvent être liés à une forte affluence ou à des problèmes de serveur temporaires. Si vous rencontrez des difficultés pour accéder à chatGPT, essayez à nouveau à différents moments de la journée.

Les périodes de faible affluence, comme tôt le matin ou tard le soir, peuvent offrir de meilleures performances et une accessibilité accrue à chatGPT.

Désactiver les extensions de navigateur potentiellement problématiques

Les extensions de navigateur, bien qu’utiles, peuvent parfois interférer avec le bon fonctionnement de chatGPT. Si vous avez des extensions installées, essayez de les désactiver temporairement pour voir si cela résout le problème.

Comment désactiver les extensions de navigateur ?

- Google Chrome : Cliquez sur les trois points en haut à droite, puis sur « Plus d’outils » > « Extensions ». Désactivez les extensions en utilisant les interrupteurs à côté de chaque extension.

- Mozilla Firefox : Cliquez sur les trois lignes en haut à droite, puis sur « Modules complémentaires ». Cliquez sur « Extensions » dans le menu de gauche, puis désactivez les extensions en cliquant sur le bouton « Désactiver ».

- Microsoft Edge : Cliquez sur les trois points en haut à droite, puis sur « Extensions ». Désactivez les extensions en utilisant les interrupteurs à côté de chaque extension.

- Safari (Mac) : Cliquez sur « Safari » dans la barre de menus, puis sur « Préférences » > « Extensions ». Désélectionnez les cases à cocher à côté des extensions pour les désactiver.

Effacer les cookies et le cache de votre navigateur

Les cookies et le cache du navigateur peuvent parfois stocker des données obsolètes ou corrompues, ce qui peut causer des problèmes avec chatGPT. Effacer les cookies et le cache peut aider à résoudre ces problèmes.

Comment effacer les cookies et le cache ?

| Navigateur | Procédure d’effacement des cookies et du cache |

|---|---|

| Google Chrome | Cliquez sur les trois points en haut à droite, puis sur « Plus d’outils » > « Effacer les données de navigation ». Sélectionnez « Cookies et autres données de site » et « Images et fichiers en cache », puis cliquez sur « Effacer les données ». |

| Mozilla Firefox | Cliquez sur les trois lignes en haut à droite, puis sur « Paramètres » > « Vie privée et sécurité » > « Cookies et données de sites ». Cliquez sur « Effacer les données », sélectionnez « Cookies et données de sites » et « Cache web », puis cliquez sur « Effacer ». |

| Microsoft Edge | Cliquez sur les trois points en haut à droite, puis sur « Paramètres » > « Confidentialité, recherche et services » > « Effacer les données de navigation ». Sélectionnez « Cookies et autres données de site » et « Images et fichiers mis en cache », puis cliquez sur « Effacer maintenant ». |

| Safari (Mac) | Cliquez sur « Safari » dans la barre de menus, puis sur « Effacer l’historique ». Sélectionnez « Toutes les données » dans le menu déroulant, puis cliquez sur « Effacer l’historique ». |

Vérifier si chatGPT est en maintenance ou rencontre des problèmes de serveur

Parfois, les problèmes de performance de chatGPT peuvent être causés par des maintenances planifiées ou des problèmes de serveur imprévus. Visitez le site web officiel de chatGPT ou leurs pages de médias sociaux pour vérifier s’il y a des annonces concernant des maintenances ou des problèmes connus.

Si chatGPT est en maintenance ou rencontre des problèmes de serveur, il n’y a pas grand-chose que vous puissiez faire de votre côté.

Dans ce cas, la meilleure chose à faire est d’attendre que l’équipe de chatGPT résolve le problème.

Envisager des alternatives à chatGPT

Si vous avez essayé toutes les étapes ci-dessus et que chatGPT ne fonctionne toujours pas correctement, il peut être temps d’envisager des alternatives à chatGPT.

Voici quelques options populaires :

- Claude : Claude est un assistant IA développé par Anthropic. Il offre des capacités similaires à chatGPT, avec un accent sur la sécurité et l’éthique.

- Llama 3 : Llama 3-1 est un modèle de langage open-source développé par Facebook AI. Il peut être utilisé pour générer du texte, répondre à des questions et effectuer d’autres tâches de traitement du langage naturel.

Bien que ces alternatives puissent ne pas offrir exactement les mêmes fonctionnalités que chatGPT, elles peuvent être des options viables si vous rencontrez des problèmes persistants avec chatGPT.